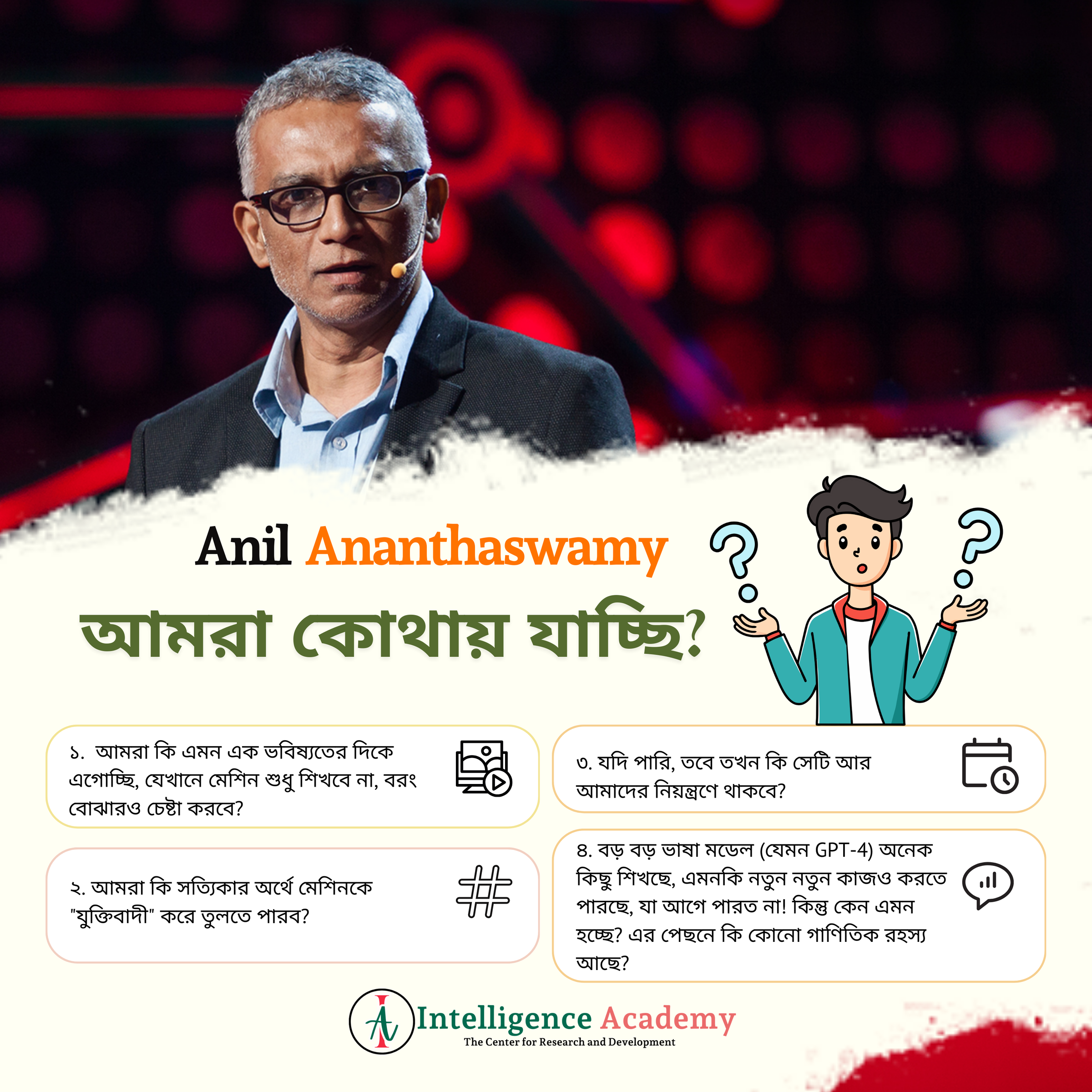

আমরা কোথায় যাচ্ছি? এআই কি সত্যিকারের বোঝে? নাকি এটা শুধু গাণিতিক প্যাটার্ন চিনতে পারে?

অনীল অনন্তস্বামী এমন একজন লেখক, যিনি বিজ্ঞানের কঠিন কঠিন বিষয়গুলোকে সাধারণ মানুষের জন্য সহজ ভাষায় তুলে ধরতে ভালোবাসেন। তিনি শুধু একজন বিজ্ঞান-সাংবাদিক নন, বরং এক ধরনের গবেষক, যিনি মহাবিশ্বের গঠন থেকে শুরু করে মানুষের চেতনা, কৃত্রিম বুদ্ধিমত্তা (এআই) থেকে নিউরোসায়েন্স—এসব নিয়ে গভীরভাবে চিন্তা করেছেন।

তিনি বেশ কিছু দারুণ বই লিখেছেন, যেখানে বিজ্ঞানের নানা জটিল বিষয় খুব সহজে, গল্পের মতো করে ব্যাখ্যা করা হয়েছে। যেমন—

📖 The Edge of Physics—এই বইয়ে তিনি আমাদের নিয়ে গেছেন পৃথিবীর নানা চরম প্রান্তে, যেখানে বিজ্ঞানীরা মহাজাগতিক রহস্যের সন্ধান করছেন।

📖 The Man Who Wasn’t There—এতে তিনি মানুষের আত্মপরিচয় আর মস্তিষ্কের রহস্য নিয়ে কথা বলেছেন।

📖 Through Two Doors at Once—কোয়ান্টাম মেকানিক্সের বিখ্যাত দ্বৈত-স্লিট পরীক্ষার গল্প বলেছেন।

📖 Why Machines Learn—এই বইয়ে তিনি বুঝিয়েছেন, আসলে মেশিন কীভাবে শেখে, আর এর পেছনের গণিতটা ঠিক কেমন!

আমাদের সবার মনে একটা প্রশ্ন প্রায়শই আসে যে মেশিন কীভাবে শেখে?

এটাই তো আসল রহস্য! আমরা যখন বলি, "মেশিন শেখে", তখন কি আসলেই ওরা বুঝতে পারে? নাকি ওরা শুধুই জটিল গাণিতিক কৌশলের মাধ্যমে ডেটার প্যাটার্ন চিনে নেয়? চলুন, একটু আরেকটু ভিতরে যাই!

১. লিনিয়ার অ্যালজেব্রা যেটা হচ্ছে নিউরাল নেটওয়ার্কের ভিত্তি। তাহলে প্রশ্ন হল একটা নিউরাল নেটওয়ার্ক কেমন দেখতে?

একদম সাধারণভাবে বলতে গেলে, এটা অনেকগুলো সংযোগযুক্ত নিউরনের স্তর, যেখানে প্রতিটা ইনপুট (যেমন একটা ছবি, টেক্সট, সংখ্যা) ধাপে ধাপে প্রসেস হয় এবং একটা আউটপুট তৈরি হয়। এটা সম্ভব হয় লিনিয়ার অ্যালজেব্রার ম্যাট্রিক্স ও ভেক্টরের মাধ্যমে।

Y=WX+B

এখানে, X = ইনপুট ডেটা, W = ওজন (weights), B = বায়াস (bias), Y = আউটপুট। এই ওজনগুলোই শেখার আসল জাদু! নিউরাল নেটওয়ার্ক যখন ট্রেন হয়, তখন ওজন (weights) আপডেট হয়—এভাবেই মেশিন শেখে!

২. অপটিমাইজেশন যেটাকে আমরা বলি গ্রেডিয়েন্ট ডিসেন্ট কৌশল। ধরুন আপনি একটা পরীক্ষায় নম্বর পেয়েছেন, কিন্তু আপনার লক্ষ্য হলো পারফরম্যান্স আরও ভালো করা। তাই কী করবেন?

২.১ ভুলগুলো বের করবেন, তারপর ঠিক করবেন!

একইভাবে, নিউরাল নেটওয়ার্কও শেখার সময় নিজের ভুল কমাতে চায়।

👉 এজন্যই ব্যবহার করা হয় "গ্রেডিয়েন্ট ডিসেন্ট", যা মূলত একটা অপ্টিমাইজেশন অ্যালগরিদম।

👉 সহজ করে বললে, এই পদ্ধতি একটা ভুল হলে সেটার ত্রুটি নির্ণয় করে, তারপর ধাপে ধাপে সেটাকে কমিয়ে দেয়!

৩. ব্যাকপ্রোপাগেশন: শেখার গোপন সূত্র

ধরুন, আপনি কাউকে ফুটবল খেলতে শেখাচ্ছেন। প্রথমে সে ভুল করবে, আপনি তাকে বলবেন কীভাবে ঠিক করতে হয়। নিউরাল নেটওয়ার্কও এভাবে শেখে!

৩.১ ব্যাকপ্রোপাগেশন মানে, যখন কোনো আউটপুট ঠিকমতো আসে না, তখন ভুলটা কোথায় হচ্ছে সেটা দেখে ধাপে ধাপে ওজন আপডেট করা হয়।

🎯 এটাই ব্যাকপ্রোপাগেশন—ডিপ লার্নিংয়ের প্রাণ!

৪. বায়াস-ভ্যারিয়েন্স ট্রেড-অফ: "ব্যালেন্স" বজায় রাখা

আপনার যদি একদম সহজ নিয়মের একটা মডেল হয়, তাহলে সে অনেক কিছুই বুঝবে না (একে বলে "হাই বায়াস")।

আবার, যদি মডেল খুব জটিল হয়ে যায়, তাহলে সে একদম ডেটার প্রতিটা অংশ মুখস্থ করে ফেলবে, কিন্তু নতুন কিছু দেখলে গুলিয়ে ফেলবে ("হাই ভ্যারিয়েন্স")।

👉 তাই দরকার একটা ব্যালেন্স!

🟢 এই ব্যালেন্স ঠিক রাখাটাই আসল চ্যালেঞ্জ!

৫. কার্স অফ ডাইমেনশনালিটি: বেশি তথ্য মানেই ভালো না!

একটা অদ্ভুত ব্যাপার জানেন? আমরা ভাবি, বেশি ডেটা মানে বেশি শক্তিশালী মডেল! কিন্তু…

⚠️ যখন ডেটার মাত্রা (dimensions) বেশি হয়, তখন অ্যালগরিদমের পক্ষে প্যাটার্ন খুঁজে পাওয়া কঠিন হয়ে যায়!

এটাকেই বলে "কার্স অফ ডাইমেনশনালিটি!"

৬. "টেরা ইনকগনিটা": অজানা অঞ্চল

অনেক সময় দেখা যায়, নিউরাল নেটওয়ার্কের প্যারামিটার বাড়ালে তার পারফরম্যান্স আরও ভালো হয়, অথচ আমরা আগে ভেবেছিলাম এটা ওভারফিট করবে! কিন্তু কেন এমন হয়?

এটা এখনো একটা রহস্য! বিজ্ঞানীরা এটাকে বলেন "টেরা ইনকগনিটা"—অজানা অঞ্চল!

তার সাম্প্রতিক বই Why Machines Learn এ তিনি অনেক Research করেছেন কৃত্রিম বুদ্ধিমত্তার (AI) শিক্ষার ধরন নিয়ে। মজার ব্যাপার হলো, আমরা যেমন ছোট থেকে চারপাশের জিনিস দেখে শিখি, আমাদের জন্য কেউ আলাদা করে "ডেটা লেবেল" করে দেয় না। মেশিনও ঠিক তেমনভাবেই শেখে—ওরা চারপাশের তথ্য থেকে প্যাটার্ন খুঁজে নেয়।

কিন্তু প্রশ্ন হলো, এটা আসলে কীভাবে কাজ করে? এর পেছনে কী ধরনের গণিত লুকিয়ে আছে?

এআই-এর শক্তি আর দুর্বলতা দুটোই আছে—

✔️ শক্তি: এআই প্রচুর ডেটার ওপর ভিত্তি করে খুব দ্রুত সিদ্ধান্ত নিতে পারে, নতুন কিছু তৈরি করতে পারে, এমনকি ভবিষ্যদ্বাণীও করতে পারে।

❌ সীমাবদ্ধতা: মডেলগুলো অসাধারণ প্যাটার্ন-ম্যাচিং করতে পারে, কিন্তু সত্যিকারের বোঝার ক্ষমতা নেই। ওরা মানুষের মতো চিন্তা করে না, কেবল ডেটার মধ্যে সম্পর্ক খুঁজে পায়।

❓ অজানা ভবিষ্যৎ: বড় বড় ভাষা মডেল (যেমন GPT-4) অনেক কিছু শিখছে, এমনকি নতুন নতুন কাজও করতে পারছে, যা আগে পারত না! কিন্তু কেন এমন হচ্ছে? এর পেছনে কি কোনো গাণিতিক রহস্য আছে?

এখন আমরা এই প্রশ্ন এর সম্মুখীন হই যে মানুষের মতো কি মেশিনও চিন্তা করতে পারবে?

এই প্রশ্নটা খুব গুরুত্বপূর্ণ। আমরা জানি, বুদ্ধিমত্তা আর চেতনার মধ্যে বড় পার্থক্য আছে।

🤖 কৃত্রিম বুদ্ধিমত্তা (AI) সমস্যার সমাধান করতে পারে, কিন্তু ওর কোনো অনুভূতি নেই।

🧠 মানুষের চিন্তা কেবল লজিক বা তথ্যের বিশ্লেষণ নয়, বরং অভিজ্ঞতা, আবেগ আর উপলব্ধির মিশেল।

⚠️ তাহলে ভবিষ্যতে কি মেশিনও মানুষের মতো অনুভব করতে পারবে? নাকি ওরা চিরকালই "প্যাটার্ন-ম্যাচিং" এর পর্যায়ে থাকবে?

অনীল অনন্তস্বামী আমাদের সাথে একটা অজানা রহস্য নিয়ে আলোচনা করে আর সেটা হল "টেরা ইনকগনিটা"

বইয়ের একদম শেষে তিনি এমন একটা বিষয় নিয়ে কথা বলেছেন, যেটাকে বলা হয় "টেরা ইনকগনিটা" বা অজানা অঞ্চল। আমরা সাধারণত ভাবি, যদি কোনো মডেলের প্যারামিটার বেশি হয়, তাহলে সেটা ওভারফিট করবে। কিন্তু অবাক করা ব্যাপার হলো, কিছু কিছু ডিপ লার্নিং মডেল বেশি প্যারামিটার থাকার পরও অনেক ভালো পারফর্ম করছে! এটা কীভাবে সম্ভব? এর পেছনের গাণিতিক ব্যাখ্যা এখনো পুরোপুরি বোঝা যায়নি।

তাহলে এখন মুল কথায় আসি, ভবিষ্যতের এআই কেমন হবে?

এখন পর্যন্ত, বেশিরভাগ এআই সুপারভাইজড লার্নিং-এর মাধ্যমে শেখে, যেখানে মানুষের হাতে লেবেল করা ডেটা দেওয়া হয়। কিন্তু অনীল বলেন, "দ্য রেভল্যুশন উইল নট বি সুপারভাইজড!" অর্থাৎ, ভবিষ্যতের এআই শুধু লেবেল করা ডেটার ওপর নির্ভর করবে না। বরং নিজেই শেখার পদ্ধতি আবিষ্কার করবে—একেবারে মানুষের মতো!

শেষ কথা হল, এআই কি সত্যিকারের বোঝে? নাকি এটা শুধু গাণিতিক প্যাটার্ন চিনতে পারে?

❓এখানেই প্রশ্ন! আমরা এখনো নিশ্চিত নই, এআই কখনো মানুষের মতো চিন্তা করতে পারবে কি না। কিন্তু আমরা জানি, এর পেছনে আছে কিছু অসাধারণ গণিত, যা একে এতটা শক্তিশালী করে তুলেছে!